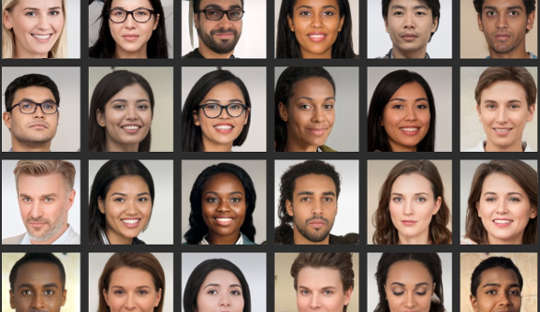

Selvom du synes, du er god til at analysere ansigter, forskning viser mange mennesker kan ikke pålideligt skelne mellem billeder af rigtige ansigter og billeder, der er blevet computergenereret. Dette er især problematisk nu, hvor computersystemer kan skabe realistisk udseende billeder af mennesker, der ikke eksisterer.

For nylig kom en falsk LinkedIn-profil med et computergenereret profilbillede i nyhederne, fordi det med succes forbundet med amerikanske embedsmænd og andre indflydelsesrige personer på netværksplatformen for eksempel. Eksperter i kontraintelligens siger endda, at spioner rutinemæssigt opretter fantomprofiler med sådanne billeder til hjem i udenlandske mål over sociale medier.

Disse dybe forfalskninger er ved at blive udbredt i hverdagskulturen, hvilket betyder, at folk bør være mere opmærksomme på, hvordan de bliver brugt i markedsføring, reklamer og sociale medier. Billederne bliver også brugt til ondsindede formål, såsom politisk propaganda, spionage og informationskrig.

At lave dem involverer noget, der kaldes et dybt neuralt netværk, et computersystem, der efterligner den måde, hjernen lærer på. Dette "trænes" ved at udsætte det for stadig større datasæt af rigtige ansigter.

Faktisk er to dybe neurale netværk sat mod hinanden og konkurrerer om at producere de mest realistiske billeder. Som følge heraf bliver slutprodukterne døbt GAN-billeder, hvor GAN står for Generative Adversarial Networks. Processen genererer nye billeder, der statistisk ikke kan skelnes fra træningsbillederne.

I vores undersøgelse offentliggjort i iScience, viste vi, at en manglende evne til at skelne disse kunstige ansigter fra den ægte vare har konsekvenser for vores onlineadfærd. Vores forskning tyder på, at de falske billeder kan erodere vores tillid til andre og dybt ændre den måde, vi kommunikerer online på.

Mine kolleger og jeg fandt ud af, at folk opfattede GAN-ansigter som endnu mere ægte ud end ægte billeder af virkelige menneskers ansigter. Selvom det endnu ikke er klart, hvorfor dette er, gør dette fund fremhæve de seneste fremskridt inden for teknologien bruges til at generere kunstige billeder.

Og vi fandt også et interessant link til attraktivitet: ansigter, der blev vurderet som mindre attraktive, blev også vurderet som mere virkelige. Mindre attraktive ansigter kan betragtes som mere typiske og det typiske ansigt kan bruges som reference som alle ansigter vurderes i forhold til. Derfor ville disse GAN-ansigter se mere ægte ud, fordi de minder mere om mentale skabeloner, som folk har bygget fra hverdagen.

Men at se disse kunstige ansigter som autentiske kan også have konsekvenser for de generelle niveauer af tillid, vi udvider til en kreds af ukendte mennesker - et begreb kendt som "social tillid".

Vi læser ofte for meget ind i de ansigter, vi ser, og de de første indtryk, vi danner, styrer vores sociale interaktioner. I et andet eksperiment, der udgjorde en del af vores seneste undersøgelse, så vi, at folk var mere tilbøjelige til at stole på oplysninger, der formidles af ansigter, som de tidligere havde vurderet som ægte, selvom de var kunstigt genereret.

Det er ikke overraskende, at folk stoler mere på ansigter, de mener er ægte. Men vi fandt ud af, at tilliden blev udhulet, når folk blev informeret om den potentielle tilstedeværelse af kunstige ansigter i online-interaktioner. De viste derefter lavere niveauer af tillid, generelt - uafhængigt af om ansigterne var ægte eller ej.

Dette resultat kunne betragtes som nyttigt på nogle måder, fordi det gjorde folk mere mistænksomme i et miljø, hvor falske brugere kan operere. Fra et andet perspektiv kan det dog gradvist udhule selve naturen af, hvordan vi kommunikerer.

Generelt har vi en tendens til at operere en standardantagelse om, at andre mennesker grundlæggende er sandfærdige og troværdige. Væksten i falske profiler og andet kunstigt onlineindhold rejser spørgsmålet om, hvor meget deres tilstedeværelse og vores viden om dem kan ændre denne "sandhedsstandard"-tilstand og i sidste ende erodere den sociale tillid.

Ændring af vores standardindstillinger

Overgangen til en verden, hvor det, der er virkeligt, ikke kan skelnes fra det, der ikke er, kan også flytte kulturlandskabet fra at være primært sandfærdigt til primært at være kunstigt og vildledende.

Hvis vi jævnligt stiller spørgsmålstegn ved sandheden af det, vi oplever online, kan det kræve, at vi omdisponerer vores mentale indsats fra behandlingen af selve beskederne til behandlingen af budbringerens identitet. Med andre ord kan den udbredte brug af meget realistisk, men kunstigt onlineindhold kræve, at vi tænker anderledes – på måder, vi ikke havde forventet.

I psykologi bruger vi et udtryk kaldet "reality monitoring" for, hvordan vi korrekt identificerer, om noget kommer fra den ydre verden eller inde fra vores hjerner. Fremskridtet af teknologier, der kan producere falske, men alligevel yderst realistiske, ansigter, billeder og videoopkald betyder, at virkelighedsovervågning skal være baseret på andre oplysninger end vores egne vurderinger. Det opfordrer også til en bredere diskussion af, hvorvidt menneskeheden stadig har råd til at misligholde sandheden.

Det er afgørende for folk at være mere kritiske, når de vurderer digitale ansigter. Dette kan omfatte at bruge omvendte billedsøgninger til at kontrollere, om billeder er ægte, at være på vagt over for profiler på sociale medier med få personlige oplysninger eller et stort antal følgere, og være opmærksom på potentialet for, at deepfake-teknologi kan bruges til uhyggelige formål.

Den næste grænse for dette område bør være forbedrede algoritmer til at opdage falske digitale ansigter. Disse kunne så indlejres i sociale medieplatforme for at hjælpe os med at skelne det ægte fra det falske, når det kommer til nye forbindelsers ansigter.

Om forfatteren

Manos Tsakiris, professor i psykologi, direktør for Center for Følelsespolitik, Royal Holloway University of London

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs oprindelige artikel.