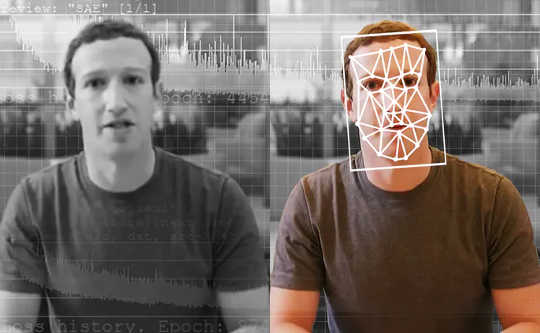

AI-drevne detektorer er de bedste værktøjer til at spotte AI-genererede falske videoer. Washington Post via Getty Images

En efterforskningsjournalist modtager en video fra en anonym whistleblower. Det viser en kandidat til præsident, der indrømmer ulovlig aktivitet. Men er denne video reel? Hvis det er tilfældet, ville det være enorme nyheder - livets skovl - og helt kunne vende det kommende valg. Men journalisten kører videoen gennem et specialværktøj, der fortæller hende, at videoen ikke er, som den ser ud. Faktisk er det en “deepfake, ”En video lavet ved hjælp af kunstig intelligens med dyb læring.

Journalister over hele verden kunne snart bruge et værktøj som dette. Om et par år kunne et værktøj som dette endda bruges af alle til at udrydde falsk indhold i deres sociale mediefeeds.

As forskere der har studeret dybfals detektion og udvikle et værktøj til journalister, ser vi en fremtid for disse værktøjer. De løser dog ikke alle vores problemer, og de vil kun være en del af arsenalet i den bredere kamp mod desinformation.

Problemet med deepfakes

De fleste mennesker ved, at du ikke kan tro på alt, hvad du ser. I løbet af de sidste par årtier er kloge nyhedsforbrugere vant til at se billeder manipuleret med fotoredigeringssoftware. Videoer er dog en anden historie. Hollywood-instruktører kan bruge millioner af dollars på specialeffekter for at udgøre en realistisk scene. Men ved hjælp af dybe forfalskninger kunne amatører med et par tusinde dollars computerudstyr og et par uger at bruge, gøre noget næsten lige så sandt i livet.

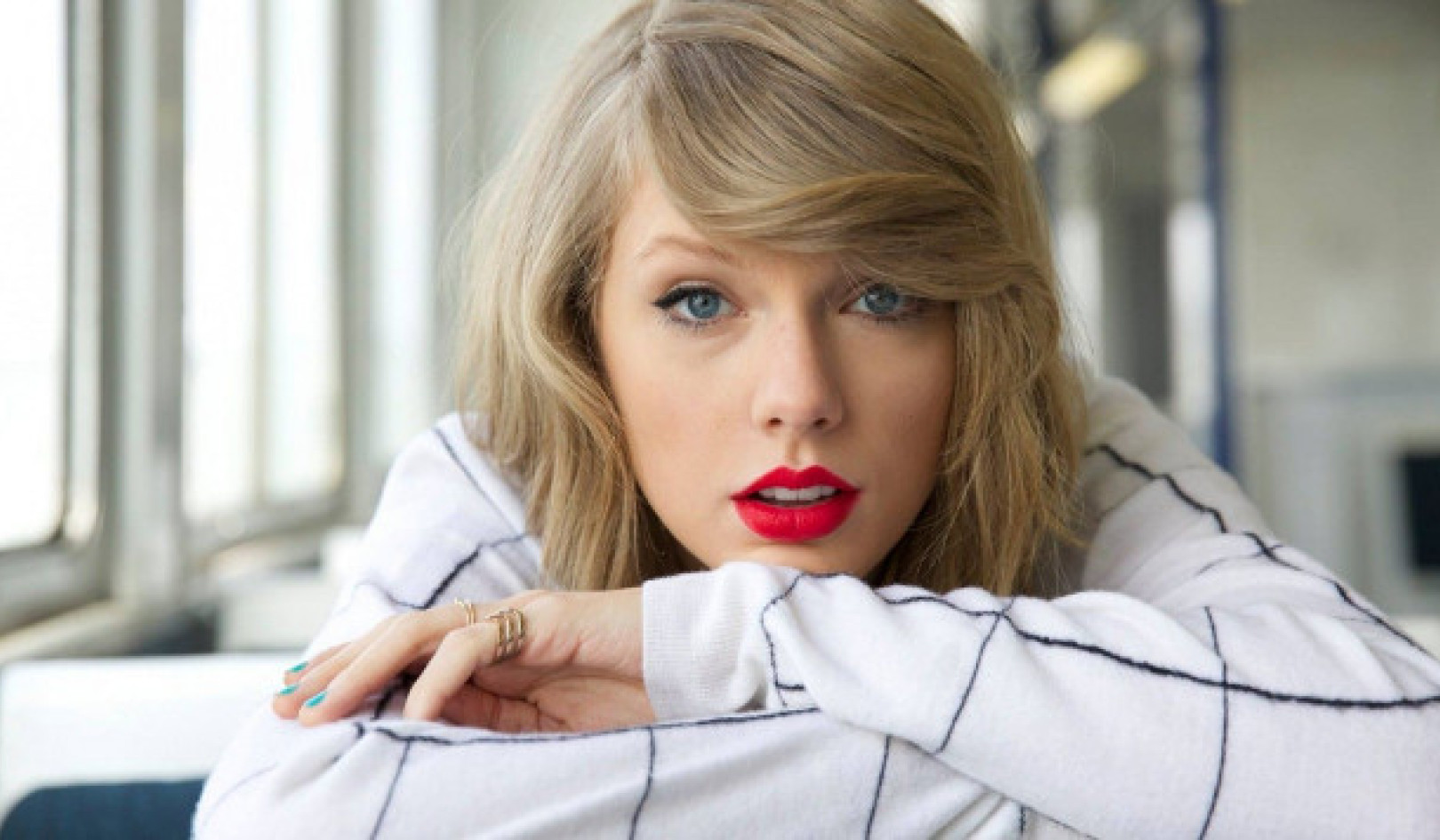

Deepfakes gør det muligt at placere folk i filmscener, som de aldrig var i - tror Tom Cruise spiller Iron Man - hvilket giver underholdende videoer. Desværre gør det det også muligt at oprette pornografi uden samtykke af de afbildede mennesker. Indtil videre er disse mennesker, næsten alle kvinder, de største ofre, når deepfake-teknologi misbruges.

Deepfakes kan også bruges til at oprette videoer af politiske ledere, der siger ting, de aldrig sagde. Det belgiske socialistiske parti udgav en ikke-falsk, men stadig falsk video af lav kvalitet Præsident Trump fornærmer Belgien, som fik nok af en reaktion til at vise de potentielle risici ved dybfakes af højere kvalitet.

{vembed Y=poSd2CyDpyA}

University of California, Berkeley's Hany Farid forklarer, hvordan deepfakes laves.

Måske skræmmende af alle, de kan bruges til at oprette tvivl om indholdet af rigtige videoerved at foreslå, at de kunne være dybe forfalskninger.

I betragtning af disse risici ville det være yderst værdifuldt at kunne opdage dybe forfalskninger og mærke dem tydeligt. Dette ville sikre, at falske videoer ikke narre offentligheden, og at ægte videoer kan modtages som autentiske.

Spotting forfalskninger

Deepfake afsløring som et forskningsfelt blev påbegyndt lidt over tre år siden. Tidligt arbejde fokuserede på at opdage synlige problemer i videoerne, såsom dybe forfalskninger, der ikke blinkede. Med tiden dog forfalskninger er blevet bedre ved at efterligne ægte videoer og blive sværere at få øje på for både mennesker og detektionsværktøjer.

Der er to hovedkategorier af dybfalske opdagelsesundersøgelser. Den første involverer ser på menneskers opførsel i videoerne. Antag at du har en masse video af en berømt person, såsom præsident Obama. Kunstig intelligens kan bruge denne video til at lære hans mønstre, fra hans håndbevægelser til hans pauser i talen. Det kan så se en dyb forfalskning af ham og læg mærke til, hvor det ikke matcher disse mønstre. Denne tilgang har den fordel, at den muligvis fungerer, selvom selve videokvaliteten i det væsentlige er perfekt.

{vembed Y=gsv1OsCEad0}

SRI Internationals Aaron Lawson beskriver en tilgang til afsløring af dybe forfalskninger.

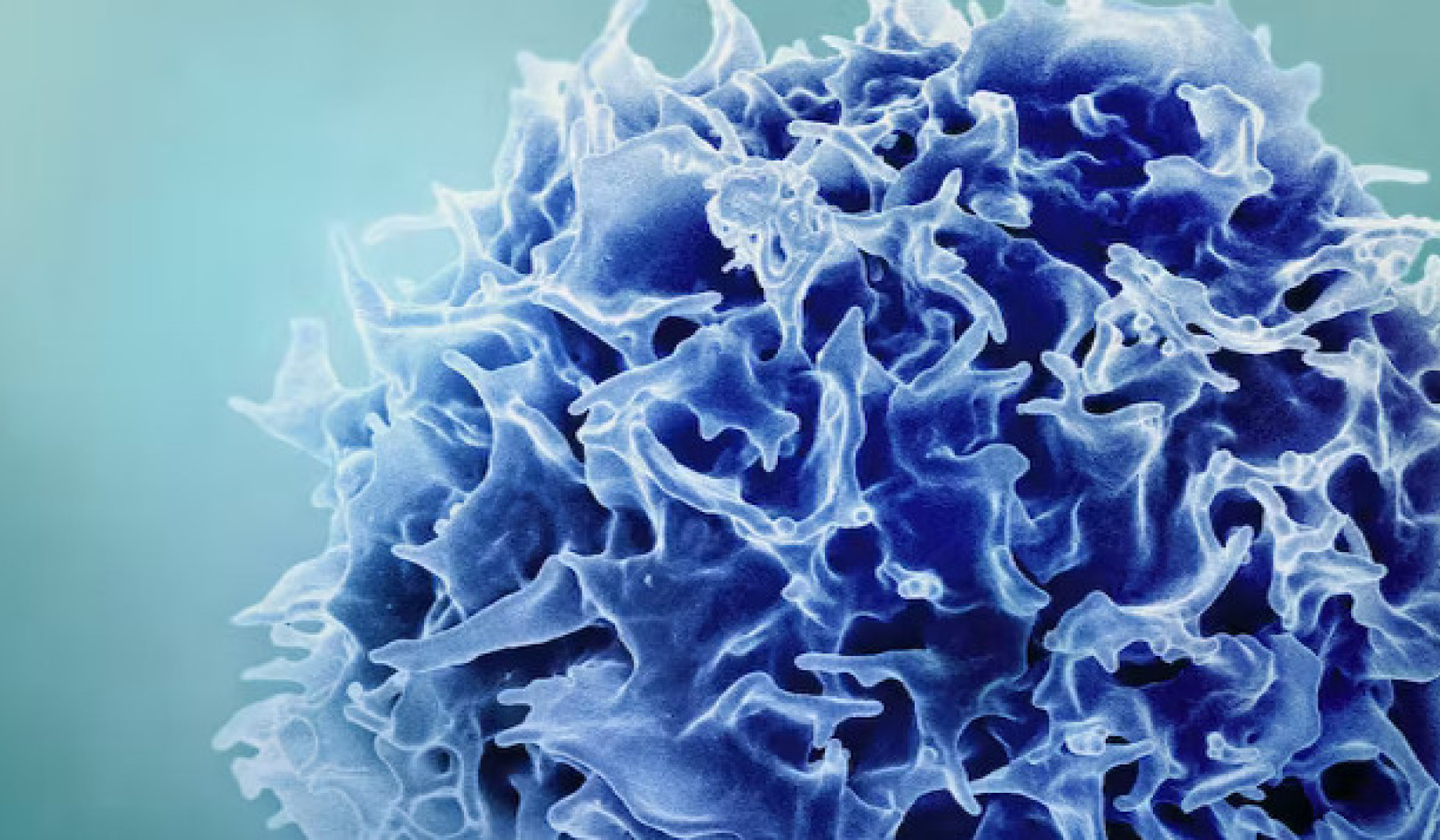

Andre forskere, inklusive vores team, har været fokuseret på forskelle at alle dybe forfalskninger har sammenlignet med rigtige videoer. Deepfake-videoer oprettes ofte ved at flette individuelt genererede rammer til at danne videoer. Når vi tager det i betragtning, udtrækker vores teams metoder de væsentlige data fra ansigterne i individuelle rammer i en video og sporer dem derefter gennem sæt af samtidige rammer. Dette giver os mulighed for at opdage uoverensstemmelser i informationsstrømmen fra en ramme til en anden. Vi bruger også en lignende tilgang til vores falske lyddetekteringssystem.

Disse subtile detaljer er svære for folk at se, men viser, hvordan deepfakes ikke er helt perfekt endnu. Detektorer som disse kan arbejde for enhver person, ikke kun for få verdensledere. I sidste ende kan det være, at begge typer dybe falske detektorer er nødvendige.

Nye detektionssystemer fungerer meget godt på videoer, der er specifikt samlet til evaluering af værktøjerne. Desværre gør selv de bedste modeller det dårligt på videoer fundet online. At forbedre disse værktøjer til at være mere robuste og nyttige er det næste vigtige trin.

Hvem skal bruge deepfake-detektorer?

Ideelt set bør et dybtfalske verifikationsværktøj være tilgængeligt for alle. Denne teknologi er imidlertid i de tidlige stadier af udviklingen. Forskere har brug for at forbedre værktøjerne og beskytte dem mod hackere, før de frigiver dem bredt.

På samme tid er værktøjerne til at lave dybe forfalskninger imidlertid tilgængelige for alle, der ønsker at narre offentligheden. At sidde på sidelinjen er ikke en mulighed. For vores team var den rette balance at arbejde med journalister, fordi de er den første forsvarslinje mod spredning af misinformation.

Inden de offentliggør historier, skal journalister kontrollere oplysningerne. De har allerede prøvede metoder, som f.eks. At tjekke med kilder og få mere end en person til at verificere nøglefakta. Så ved at sætte værktøjet i deres hænder, giver vi dem mere information, og vi ved, at de ikke vil stole på teknologien alene, da det kan begå fejl.

Kan detektorerne vinde våbenkapløbet?

Det er opmuntrende at se hold fra Facebook , microsoft investere i teknologi til at forstå og opdage dybe forfalskninger. Dette felt har brug for mere forskning for at holde trit med fremskridtene inden for dybfalske teknologier.

Journalister og de sociale medieplatforme skal også finde ud af, hvordan man bedst advarer folk om dybe forfalskninger, når de opdages. Forskning har vist det folk husker løgnen, men ikke det faktum, at det var en løgn. Vil det samme være tilfældet for falske videoer? Simpelthen at sætte “Deepfake” i titlen er måske ikke nok til at imødegå nogle former for desinformation.

Deepfakes er kommet for at blive. Håndtering af desinformation og beskyttelse af offentligheden vil være mere udfordrende end nogensinde, da kunstig intelligens bliver mere magtfuld. Vi er en del af et voksende forskningsmiljø, der påtager sig denne trussel, hvor afsløring er bare det første skridt.![]()

Om forfatterne

John Sohrawardi, doktorand i computer- og informationsvidenskab, Rochester Institute of Technology og Matthew Wright, professor i computersikkerhed, Rochester Institute of Technology

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs original artikel.